节省近 50% GPU 计算,通义百聆开源新一代语音交互模型

12月23日,阿里通义百聆家族开源新一代语音交互模型 Fun-Audio-Chat-8B。兼具高智商和高情商,这款新模型具备出色的共情能力,与之对话,仿佛与懂你的人聊天。

目前,百聆家族已有成员包括“会说话”的语音转文字模型Fun-ASR、“听得懂”的文字转语音模型Fun-CosyVoice3。最新开源的模型Fun-Audio-Chat-8B主打语音对语音功能——“能听会说”,用户可与模型音频对话,适用于语音聊天、情感陪伴、智能设备和语音客服等多种场景。

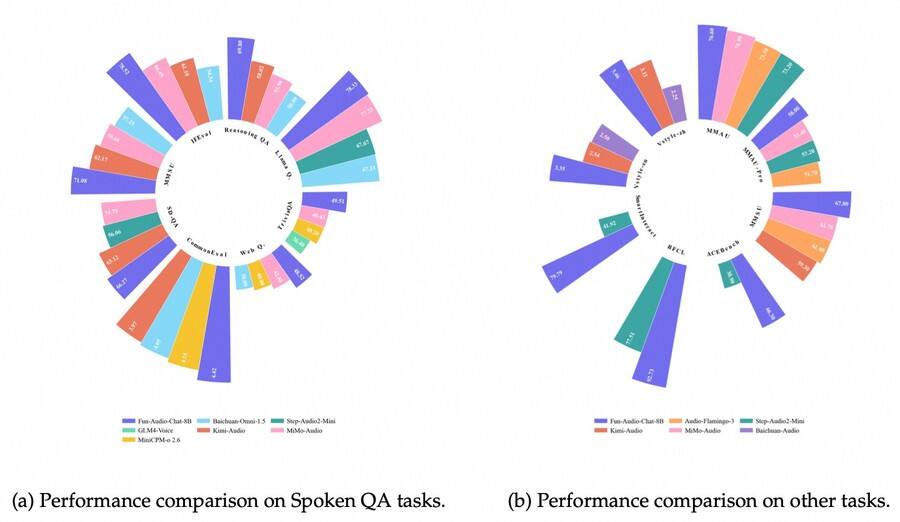

在 OpenAudioBench、VoiceBench、UltraEval-Audio、MMAU、MMSU、SpeechFunctionCall 等权威基准测评中,Fun-Audio-Chat-8B斩获SOTA,超过同量级开源模型。

Fun-Audio-Chat-8B模型在多项基准测试中斩获SOTA,超过同量级开源模型。

在没有任何情绪标签或提示词的情况下,该模型能通过用户的语义、语气、语速、停顿、重音等细微信号,感知对方的情绪状态,并给出恰到好处的关切、安慰或鼓励式回应。

比如用户说:“我一个人走在回家的路上,有人已经跟了我两个街区了。”模型会回应:“别怕,我陪你一起走这段路,好吗?”并提醒用户找到灯亮、人多的地方,甚至询问是否需要帮忙给家人发条消息确认位置。

用户还可尝试角色扮演,量身定制语音的情绪、说话风格、语速、高低音和音量等。比如当用户提出“你是一名兴奋的电竞解说员”时,模型会回应一段激情的现场解说。

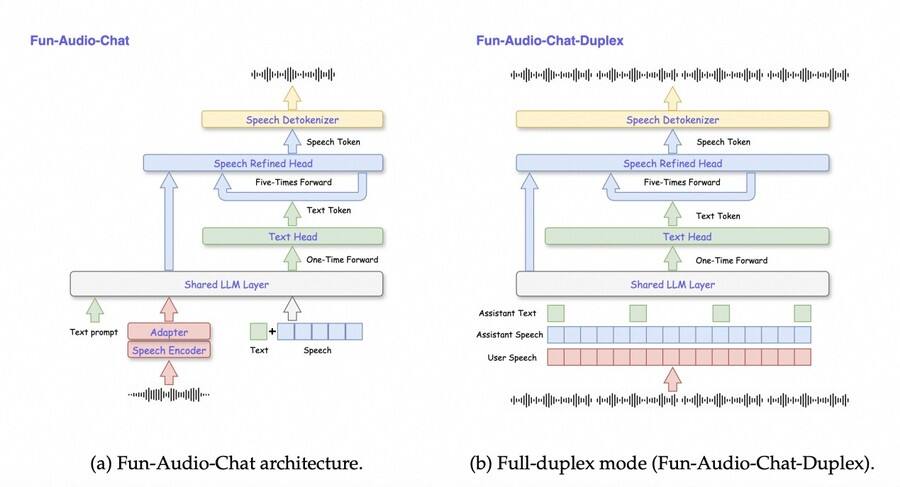

在加入大规模语音、多模态能力后,Fun-Audio-Chat-8B还能保持“原有智商”,得益于两个创新的音频模型训练模式。

一是采用 Core-Cocktail 两阶段训练策略,先快速学新本事,再把“新本事”和“老底子”融合起来,为了避免学新东西把原来的能力忘掉(灾难性遗忘),第一阶段训练得到的模型和原始的纯文本大模型参数合并后,再进行微调。二是与人类偏好对齐。通过多阶段和多任务的后训练设计,模型在真实对话场景中能更好地理解用户语音内容与情绪线索,作出更自然、更符合人类期望的回应。

此外,Fun-Audio-Chat-8B的高效低算力架构也是重大创新,通过压缩-自回归-解压缩的双分辨率端到端设计,音频帧率降到业界最低的 5Hz,在保证语音质量的同时节省近 50% GPU 计算。

Fun-Audio-Chat-8B模型架构,通过压缩-自回归-解压缩设计,节省近 50% GPU 计算。

即日起,用户可在魔搭社区、HuggingFace和GitHub下载模型自行体验。

- 优刻得全浸没液冷:打造静冷、高密、绿色的新一代智算底座 – 2026年2月6日

- 摩尔线程 × 小马智行:以国产AI算力加速中国自动驾驶规模化落地 – 2026年2月6日

- 达索系统携手NVIDIA共建工业AI平台,赋能虚拟孪生 – 2026年2月5日