近日,摩尔线程正式发布开源大模型分布式训练仿真工具SimuMax的1.1版本。该版本在完整继承v1.0高精度仿真能力的基础上,实现了从单一工具到一体化全栈工作流平台的重要升级,为大模型训练的仿真与调优提供系统化支持。

本次更新聚焦三大核心创新:用户友好的可视化配置界面、智能并行策略搜索,以及融合计算与通信效率建模的System-Config生成流水线。新版本同时提升了对主流训练框架Megatron-LM的兼容性,并增强了对混合并行训练中复杂通信行为的建模精度,使仿真环境更贴近真实生产场景。

SimuMax是一款专为大语言模型(LLM)分布式训练负载设计的仿真模拟工具,可为单卡到万卡集群提供仿真支持。它无需实际执行完整训练过程,即可高精度模拟训练中的显存使用和性能表现,帮助用户深入洞察训练效率,探索提升计算效能的优化途径。

平台升级:从精准仿真到智能工作流

SimuMax v1.1在高精度仿真能力的基础上,通过以下多项功能构建了更完整、更智能的工作流:

▼ 智能并行策略搜索:引入策略搜索支持,自动探索并识别更优的并行化及执行策略,降低调参成本,提升训练效率;

▼ 系统配置生成流水线:新增系统配置文件生成流水线,包含计算效率与通信效率的刻画,以实现更真实的系统级建模;

▼ 增强的框架兼容性与优化:新增对Megatron-LM v0.14的支持,主要适配了新版本Moe Router的显存优化特性;

▼ 精细化带宽争用建模:专门优化了在专家并行(EP)/张量并行(TP)与数据并行(DP)混合场景下的节点间网络带宽竞争模拟,提升大规模集群仿真的准确性。

体验革新:可视化界面,赋能极简操作

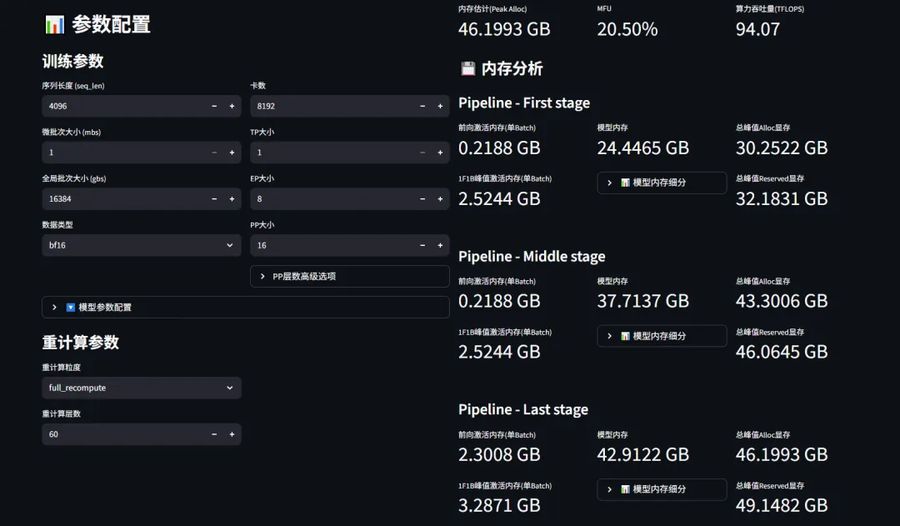

SimuMax v1.1引入了直观的可视化配置界面。用户通过简单交互,即可快速完成从单卡到万卡集群的训练任务定义,极大简化工作流,使工程师更专注于训练策略设计与深层性能优化,提升模型研发与调优效率。

图示:SimuMax v1.1的可视化配置界面

快速开始:四步启动高效仿真

开发者可通过以下步骤,快速体验SimuMax:

1.克隆仓库:

1)git clone git@github.com:MooreThreads/SimuMax.git

2)cd SimuMax

2.安装Python包:

1)pip install -r requirements.txt

2)pip install -v -e .

3.运行示例:

参考项目中的教程和示例(如examples/perf_llama3_8b_tp1_pp2.py),即可开始使用SimuMax进行训练仿真。

4.启动SimuMax应用:

开发者可以选择启动SimuMax应用,访问交互式配置界面。

1)cd app

2)bash install.sh

3)streamlit run streamlit_app.py

持续优化与生态共建

SimuMax已在GitHub全面开源,开发者可访问仓库获取源代码、详细文档和示例。摩尔线程鼓励开发者通过提交Issue报告问题或通过Pull Request贡献代码,共同促进SimuMax功能的完善和软件生态的繁荣。

▼SimuMax GitHub开源地址:

https://github.com/MooreThreads/SimuMax

▼ SimuMax v1.1版本:

https://github.com/MooreThreads/SimuMax/releases/tag/v1.1

摩尔线程始终致力于为开发者提供高效、创新的软件工具链。SimuMax的发布,为大模型分布式训练提供了从可视化配置、自动化策略推荐到高精度仿真的完整工作流,助力AI产业提升算力利用率,探索更高效、更智能的训练范式。

未来,SimuMax团队将持续迭代,计划进一步扩展平台能力,包括支持ViT模型、引入大规模训练的数据并行(DP)衰减估计,以及支持计算通信重叠(TP/EP Overlap)模拟等功能,不断突破训练仿真优化的技术边界。

- 摩尔线程联合五一视界,共建全栈国产化的物理AI仿真体系 – 2026年2月24日

- 蚂蚁集团AI业务春节加速:支付宝“AI付”、蚂蚁阿福APP用户数双破亿 – 2026年2月24日

- 阿里云Coding Plan上新,支持千问3.5、GLM-4.7等模型 – 2026年2月22日